Was ist Value at Risk?

Value at Risk (VaR) ist ein Risikomaß.

Bei Banken und auch Versicherungen hat die Risiko-Kennzahl "Value at Risk" seit Mitte der 90er Jahre einen fast kultartigen Status erreicht. Um die Jahrtausendwende war es bei den Risikoanalysten gerade zu dem Zeitpunkt das Maß aller Dinge, als in den USA die Immobilienblase platzte.

Mir ist sie in letzter Zeit immer wieder bei besonders "progressiven" und "wissenschaftlichen" Finanzdienstleistern untergekommen. Ich habe mich gefragt: "Was ist denn dieses Value at Risk genau?"

Die Definition

Definiert wird der Value at Risk als der höchste zu erwartende Verlust eines Wertpapiers, der mit einer zuvor definierten Wahrscheinlichkeit innerhalb eines fest bestimmten Zeitraums nicht überschritten wird.

Value at Risk beantwortet Fragen wie

Wie viel Geld darf ich in Daimler-Aktien investieren, wenn ich bei einer Haltedauer von einem Monat mit einer Wahrscheinlichkeit von 95 % nicht mehr als 500 Euro verlieren möchte?

Schauen wir uns einmal die Schwellenländer an.

Wir betrachten den Zeitraum zwischen Anfang Januar 1988 und Ende Dezember 2012. Das sind 25 Jahre oder 300 Monate.

Was uns interessiert: Mit welchen Verlusten müssen wir als Anleger in jedem der schlechtesten 5 % der betrachteten Monate mindestens rechnen?

Hier kommt die Value-at-Risk-Kennzahl ins Spiel. Da wir uns auf die schlechtesten 5 % konzentrieren wollen, ist unser Value-at-Risk-Niveau das 95%-Niveau.

Würden wir uns für das schlechteste 1 % in der Zeit zwischen 1988 und 2012 interessieren, wäre unsere VaR-Kennzahl das 99%-Niveau.

Das VaR-Niveau sagt uns der Verkäufer, denn er nutzt es als Verkaufsargument. Ihre Aufgabe: Sie müssen verstehen, was der Satz: "Das 95%-VaR-Niveau liegt bei -12,11 %".

Fangen wir an:

95 % bedeutet: Wir betrachten die schlechtesten 5 % der Monate. Unsere Zeitspanne umfasst 300 Monate. 5 % von 300 Monaten sind 15 Monate. Immerhin ein Jahr und ein Quartal.

-12,11 % bedeutet: In den schlechten Monaten wird Ihr monatlicher Verlust mindestens 12,11% betragen.

Fazit: In 15 von 300 Monaten wird Ihr Schwellenland-Investment um mindestens 12,11 % schrumpfen.

Beachten Sie zwei Dinge:

- Schrumpfen bedeutet nicht, dass Sie absolut gesehen Verluste machen. Wenn Ihr Depot vorher entsprechend gestiegen ist, können Sie trotzdem noch im Plus sein.

- VaR macht keine Aussage über den größten anzunehmenden Unfall. Was genau in diesen letzten 5 % passiert, darüber schweigt sich diese Kennzahl aus. Die Verluste können auch 20 %, 30 % oder 50 % betragen. Die 12,11 % sind ein Mindestverlust. Es kann auch ‒ deutlich ‒ mehr werden.

Die Probleme

Mit Value at Risk verschleiere ich das Risiko

Nehmen wir den Satz: "Die Wahrscheinlichkeit, dass ich mit diesem Investment 100 Millionen Euro oder mehr verliere, liegt nur bei 5 Prozent."

Mathematisch nicht zu beanstanden. Das Problem sind die zwei Worte "oder mehr", die im folgenden Verkaufsgespräch nicht mehr erwähnt werden.

Damit verlieren Sie als Anleger die maximalen Verlustrisiken aus den Augen. Value at Risk verschafft Investment-Managern die Möglichkeit, Risiken in enormem Umfang zu verstecken. Gerade bei komplexen Finanzprodukten geht das sehr einfach.

"Solange eine Bank über Value at Risk eine beliebige Menge an Risiken verbergen kann, ist es völlig egal, ob sie eine Eigenkapitalquote von 8 Prozent oder von 30 Prozent hat."

Prof. Dr. Frank Riedel vom Institut für mathematische Wirtschaftsforschung in Bielefeld

Ein niedriges VaR bedeutet nicht, dass die empfohlene Anlageform besonders Crash-sicher ist. Es bedeutet nur, dass sie im Allgemeinen recht wenig schwankt. VaR ist ein Schönwetter-Risikomaß, denn was bei einem Extremereignis passiert, ist nicht Teil des Modells. Aber genau dieser Bereich ist für uns als Anleger besonders wichtig.

Value at Risk sagt nichts über das "Wann" aus

Das VaR-Modell gibt auch keine Auskunft über die Periodizität. In unserem Beispiel bedeutet das: Die Kurse der Schwellenland-Aktien können 23 Jahre und neun Monate steigen und in den letzten 15 Monaten geht es dann jeden Monat um mindestens 12,11 % nach unten.

Mit anderen Worten: Längere Dürreperioden lassen sich mit diesem Modell nicht vorhersagen.

Dazu kommt, dass die VaR-Kennzahl für langfristige Anleger sowieso nur einen sehr geringen Wert besitzt.

VaR bezieht sich immer auf einen Zeitraum. Wenn dieser "unendlich" ist, versagt das Modell.

Die VaR-Berechnung wurde für eine Haltedauer von einem Tag entwickelt, nicht für die normalen Anleger mit einem Anlagehorizont von 5 bis vielleicht 30 Jahren. Wenn ich einen so langen Anlagehorizont habe und dann mit diesem Risikomaß arbeite, das für einen Tag designt ist, dann ist das doch offensichtlich absurd. Hier werden Langfristanleger mit Instrumenten bedient, die eigentlich für Daytrader gedacht sind.

Fazit

Value at Risk ist nicht "Schwarzer-Schwan-sicher". Seltene Ereignisse, die grausam zuschlagen, brechen der VaR das Genick.

Nur mit Value at Risk lässt sich kein Depot sinnvoll absichern. Lassen Sie sich nicht einwickeln von listigen Verkaufsfüchsen, die ihnen mit pseudo-wissenschaftlichen Begründungen das Geld aus der Tasche ziehen wollen.

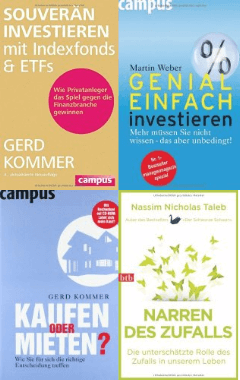

Zum Weiterlesen

Dr. Fox verführt zuverlässig. Auch Sie!

(awa)

Der Freitags-Newsletter

Hat Ihnen dieser Artikel gefallen? Wollen Sie wisssen, wenn sich hier etwas tut (unter anderem neue Artikel, Veranstaltungen mit und von mir)? Wenn ja, dann melden Sie sich zum Freitags-Newsletter an.

Ja, ich bin dabei!

kurz & bündig, kostenlos, kein Spam, keine Weitergabe der E-Mail-Adresse, jederzeit kündbar, Datenschutz

Abgelegt unter Strategie, Geldanlage, Grundlagen, Rendite, Risiko, Aktien

Das könnte Sie auch interessieren

- Sind Sie schon ein Vermögenswert oder noch eine Verbindlichkeit?

- Wenn Finanzvertriebler zu Hyänen werden

- Bill Gates kauft Land - will ich auch

- Soll ich mein Geld nachhaltig anlegen?

Kommentare

Pin Gu sagt am 03. März 2016

Vielen Dank! Wieder scharfsinnig auf den Punkt gebracht!

Das Thema beschäftigt mich momentan auch sehr stark nach einer Diskussion mit den Jungs von scalable capital letztens auf einer Veranstaltung. VaR wird bei denen als das Alleinstellungsmerkmal ggü Mitbewerber sehr stark strapaziert.

Rendite können die Jungs nicht voraussehen, aber Risiko auf Jahre schon! Marketing Gelaber von Ex-Goldman Sachs Jungs ;-) Konkurrenz steigt, da muss man in Wording kreativ werden.

Chris sagt am 03. März 2016

Jedes Modell ist halt immer nur so gut wie die Annahmen, die darin reingesteckt werden.

Das "Dilemma" bei der Risikobewertung (was ja nicht nur Finanzprodukte, sondern im Grunde jede Tätigkeit, bei der Verluste möglich sind, betrifft) ist im Grunde ja immer dasselbe: Woher nehme ich meine Erwartungen (zB. über mögliche Verluste) in der Zukunft überhaupt her ?

Die naheliegendste Antwort, auf die wohl die meisten sofort kommen würden, lautet natürlich: Na, aus den bisher aufgetretenen Verlusten der Vergangenheit, was denn sonst!

Klassische empirische Methode eben, wogegen ja prinzipiell nichts einzuwenden ist, wenn die verbleibende Alternative wäre, sonst einfach nur irgendwelche Zahlen blind aus der Luft zu greifen (oder ganz auf jegliche Konsideration von Risiko zu verzichten und einfach hasardeurisch drauflos zu handeln).

Die dabei auftretenden Probleme, oder sagen wir eher "Grenzen, an denen sich solch allgemeine Modelle in zunehmender Unschärfe verlieren" (zu wirklichen Problemen werden die ja erst, wenn ich mein Handeln stur darauf ausgerichtet habe, dass nur Ereignisse innerhalb des Modells auftreten werden) hast du schon einiges beschrieben.

Die Kritik wird aber nicht nur speziell VaR betreffen, sondern so ziemlich alle Kennzahlen, die aus Vergangenheitsdaten konstituiert werden, haben eben die selbe Eigenschaft - sie beschreiben eben nur, was bisher passierte. Aussagen darüber, was darüber hinaus weiter in Zukunft zu erwarten ist, lassen sich dadurch jedoch nur sehr bedingt und mit gehörigen Einschränkungen ableiten.

Nicht umsonst muss ja unter jedem Chart im Verkaufsprospekt immer zwingend ein Disclaimer ala "Historische Entwicklungen sind keine Garantie für die Zukunft" stehen, und was für die Rendite gilt, ist natürlich auch beim Risiko nicht anders.

"Damit verlieren Sie als Anleger die maximalen Verlustrisiken aus den Augen."

Was ist überhaupt ein "maximales Verlustrisiko", und wie kann man es seriös ermitteln ? Rein empirisch betrachtet kann das ja nur der größte bisher aufgetretene Verlust sein.

Das Problem dabei ist natürlich, dass man sich zwangsläufig immer der Gefahr aussetzen muss, dass ein nächsthöherer Verlust aber immer noch in der Zukunft auf einen warten kann.

Der größte bisherige Verlust beim MSCI World beispielsweise war etwa -57%, das kann zwar einen ersten Anhaltspunkt geben, es ist jedoch aber natürlich nicht für alle Ewigkeit in Stein gemeißelt, dass nicht in Zukunft auch mal größere Verluste von -70%, -90% etc auftreten werden könnten.

Als Spitze daraus könnte man auch einfach so ziemlich allen Anlagen pauschal einen möglichen Maximalverlust von 100% unterstellen, was einem aber auch nicht die Frage beantwortet, wie wahrscheinlich gerade dieser Fall nun wieder sein könnte, und ob das wirklich eine in der Praxis vernünftig umzusetzende Vorgehensweise ist.

Denn nur darum geht es ja im Endeffekt eigentlich konkret: Die Kennzahlen an sich sind erstmal nur Nummern, wichtig ist, wie man mit ihnen umgeht, welche Schlüsse man daraus zieht und welche Handlungen davon abgeleitet werden.

Auf der anderen Seite sind ja auch so "positive" Dinge wie zB. "langfristig betrug die durchschnittliche Rendite beim MSCI World ca 7% pa" auch nicht einfach so für die Zukunft wirklich "garantiert" (ganz abgesehen davon, dass innerhalb der Langfristigkeit auch immer große Abweichungen vom Durchschnitt, nach oben und nach unten, auftreten) und nur bedingt aus der Vergangenheitsentwicklung sicher zu schlussfolgern.

Nur weil das bisher so war, muss das nicht unbedingt weiter so sein. Kann mehr werden, oder auch weniger. Natürlich kann man ein paar vernünftige Annahmen treffen, warum es so oder so kommen wird, am Ende bleibt aber immer ein gewisser Rest Unsicherheit übrig, dem man eben mit einem nicht weiter begründbaren Grundoptimismus begegnen muss, wenn man das Geld nicht einfach nur auf dem Sparbuch bunkern lassen will.

So richtig problematisch werden auch Risikokennzahlen erst wirklich, wenn man sie benutzt, ein System bis zum ("theoretisch verkraftbaren") Limit hochzuhebeln um den möglichen Profit zu maximieren.

Wer zum Beispiel eine Aussage wie "Bei Anlage XY ist ein Maximalverlust größer als -5% noch nie aufgetreten" als Einladung versteht, deswegen gleich mal quasi "gefahrlos" auf den Faktor 20 hochhebeln zu können, der bettelt quasi nur darum, dass die schwarzen Schwäne mal zum Besuch bei ihm einfliegen.

Schönes Beispiel ist der FX-Sektor, wo ja sachbedingt Leverage Usus ist. Dann können wir uns nach so Ereignissen wie dem Franken-Schock letzten Jahres anhören, dass eine 20%-Tagesveränderung einer solchen Währung statistisch eigentlich nur einmal aller xtrillionen Jahre mal auftreten sollte.

Tja, Pech den Tradern, die sich an solchen theoretischen Modellen orientiert haben. Funktioniert die meiste Zeit vielleicht prächtig, bis es eben nicht mehr funktioniert.

Auch basierte genauso die angesprochene US-Immobilienblase im Grunde nur auf "Home Prices have never gone down!" => therefore they will never go down! Zur Finanzkrise breitete sich das aus, weil auch die "Profis" auf ähnlich naiven Annahmen hochgehebelt untereinander gemauschelt hatten.

"Dazu kommt, dass die VaR-Kennzahl für langfristige Anleger sowieso nur einen sehr geringen Wert besitzt.

VaR bezieht sich immer auf einen Zeitraum. Wenn dieser "unendlich" ist, versagt das Modell."

Bei unendlich versagt so ziemlich jedes Modell, besonders weil es keine Möglichkeit gibt, "exogene" Ereignisse vernünftig zu quantifizieren. Es gibt auch eine theoretische Wahrscheinlichkeit, dass einmal aller paar Millionen Jahre ein Komet einschlagen kann der alles höhere Leben auf der Erde auslöscht, was natürlich auch nichts darüber aussagt ob das nun unbedingt morgen oder in einer Million Jahren passieren wird.

Nur eins ist sicher, wenn der Fall mal irgendwann eintritt, sind unsere Aktien-Totalverluste das geringste Problem :-D

Aber was deine Kritik an VaR speziell angeht, das gleiche Prinzip gilt ja auch für deine "Feuerübung"-Methode: Wenn wir gefragt werden, wieviel man in Aktien investieren sollte, ist die erste Gegenfrage ja "wieviel Verlust kannst du denn ertragen?", und dann wird das Verhältnis der RK1 und RK3 Anteile mittels einer unterstellten Crashsituation (z.b. -50%, weils schön zu rechnen ist und auch in etwa den bisher aufgetretenen Verlusten entspricht) im Dreisatz berechnet.

Schön leichtverständlich, so dass sie auch von jedem umgesetzt werden kann (deswegen empfehle ich Anfängern ja ähnliches), und man brauch vor allem keine Experten für ihre komplexen Analysedienste bezahlen. Aber die selbe Rest-Unsicherheit bleibt prinzipiell bestehen, dass auch mal ein Crash viel größer als die bisherigen Erfahrungswerte auftreten kann.

Das grundlegende Problem kann damit auch nicht wirklich gelöst werden, aber wenigstens tun wir ja auch nicht so und wollen vor allem niemanden was als besonderes Sicherheitskonzept damit verkaufen.

"Nur mit Value at Risk lässt sich kein Depot sinnvoll absichern."

Welche Definition von "absichern" benutzt du ? Einfach nur die blanken Zahlen allein können natürlich garnichts "absichern", es geht am Ende immer nur um die praktischen Handlungen, für die man diese Zahlen letztlich als Orientierung benutzt.

Ich denke mal dir geht es vor allem um die Methode von den neuen Robos, die ein Investmentportfolio nach Ziel-VaR optimiert zusammenstellen und stetig anpassen wollen. Die Diskussion unter dem Artikel war ja schon sehr intensiv, und vielleicht stellt sich auch hier mal wieder einer der Anbieter deiner konkreten Kritik.

Die theoretischen Hintergründe der Modelle wurden eigentlich m.M. schon relativ nachvollziehbar dargelegt, allerdings habe ich aus eigener Erfahrung mit dem programmieren ähnlicher automatischer Handelsmodelle wohl schon gewisse Vorkenntnisse, was die praktische Anwendung (und auch Grenzen) davon angeht.

Plus, ich mach das ja nur für mich selbst und will niemandem was verkaufen - wenn ich mich mal geirrt habe, ist wenigstens nur mein eigenes Geld weg, lol.

Die Frage, ob VaR o.ä. "funktioniert" (also langfristig zuverlässig Verluste in den vorgesehenen Grenzen hält, und der ganze (Kosten!)Aufwand überhaupt einen Mehrwert gegenüber normalem B&H bringt), bleibt in der Zukunft abzusehen, da es keine Vergangenheitsperformance zum nachprüfen gibt.

Um dem ganzen trotzdem noch Vertrauen zu schenken, muss das Konzept vor allem verständlich sein (wie gesagt, deswegen bevorzuge ich die eigene Programmierung, da versteht man alles).

B&H ist dagegen für jeden verständlich und bringt auch eine belastbare Historie mit. Je komplexer die Konzepte dagegen werden, umso fragiler werden sie auch meist, da immer mehr Annahmen hineinfließen (von denen die Chance steigt, dass sie sich irgendwann auch als falsch herausstellen und das System kippt).

Hoeness Steuerberater sagt am 04. März 2016

Value at Risk allein ist gefährlich, aber zusammen mit Maximum Drawdown (also Maximalverlust innerhalb einer betrachteten Periode) schon eine gute Kennziffer.

Beispielsweise beim MSCI Emerging Markets im Factsheet von MSCI enthalten, und man lernt: 65% Maximalverlust.

Das ist natürlich keine Garantie, dass es nicht irgendwann noch schlimmer werden kann, aber an diesen -65% kann man sich festhalten.

Link zum Factsheet: https://www.msci.com/resources/factsheets/index_fact_sheet/msci-emerging-markets-index-gross.pdf

Alexander@klarplus sagt am 04. März 2016

Der Bezug auf Vergangenheitswerte macht das Konzept angreifbar, wie jedes andere auch. Wer sagt mir denn, dass die sich die Ergebnisverteilung nicht ändert und die Glockenkurve sich in der Zukunft nicht verzerrt? Bzw. gilt beim "reaktiven Forschungsobjekt Mensch bzw. Anleger" die Glockenkurve überhaupt noch? Man weiß es nicht.

Trotzdem mach VaR Sinn. Aus meiner Sicht ist VaR dann am sinnvollsten, wenn man sich nicht an absolute Werte hält sondern sich die Verhältnismäßigkeit anguckt.

Wenn ich zwei Werte habe, der eine Wert mit VaR 95: -5 und der andere mit -20, dann weiß ich dass der zweite Wert sehr viel risikoreicher angelegt ist. Ich kann nicht unbedingt davon ausgehen, dass ich diesen Verlust nicht unterschreite, aber die Verhältnismäßigkeit bleibt wahrscheinlich gleich.

Wenn sich der Markt fundamental ändert (z.B. kurzzeitig 2008) und aus der "Normalverteilung" gerät, dann tut er das wahrscheinlich nicht nur für eine Assetklasse.

Der stabilere Wert wird auch dann stabiler bleiben. Kombiniert mit Korrelationsannahmen kann ich mein Portfolio so schon versuchen zu optimieren, es möglichst breit und schlau aufstellen - auch wenn ich die angekündigen Verluste immer unterschreiten kann.

Finanzwesir sagt am 04. März 2016

@Chris und Alexander: Klar, aber ich wende mich vor allem gegen die verkäuferische Verkürzung: "Schwankt nur 5%, ist sicher... "

"Wenn sich der Markt fundamental ändert (z.B. kurzzeitig 2008) und aus der "Normalverteilung" gerät, dann tut er das wahrscheinlich nicht nur für eine Assetklasse."

Hm, das würde mich wirklich mal interessieren, ob das so ist, oder ob es dann nur noch zwei Anlageklassen gibt: "Deutsche und US-Staatsanleihen" und den Rest.

Ein bißchen überspitzt, aber soll sagen: In Panikmomenten gibt es nur noch Sachen, die als risikoarm betrachtet werden und Dinge, die - vollkommen undifferenziert als riskant gelten.

Gruß

Finanzwesir

Chris sagt am 04. März 2016

"Klar, aber ich wende mich vor allem gegen die verkäuferische Verkürzung: "Schwankt nur 5%, ist sicher... "

Ist das Problem dabei der Verkäufer oder der ungebildete Kunde, der das selbst so falsch glaubt?

An den wendest du dich ja in deinem Artikel eigentlich (richtigerweise, da es wenig bringt einfach nur von den Anbietern zu verlangen "Hey, könntet ihr bitte eure Werbung realistischer halten?" anstatt vielmehr schon den (potentiellen) Kunden zu sagen "Leute, denkt auch mal ein bischen selber nach und lasst euch nicht einfach so nur einlullen").

Bei allem Marketing-Blabla muss die Rechtsabteilung der Anbieter ja auch immer drauf achten, dass trotzdem jede Behauptung juristisch wasserdicht bleibt und überall mit den nötigen Sternchen und Kleingedruckten versehen ist.

Man muss sich halt nur die "Mühe" machen das auch alles wirklich durchzulesen, dann relativiert sich hinter den Schaufenster-Texten auch wieder vieles (blabla, Verluste können größer als erwartet ausfallen, blubblub keine Garantien, blöblö Kapitalmarktrisiken etc, das übliche Zeugs halt).

"Hm, das würde mich wirklich mal interessieren, ob das so ist, oder ob es dann nur noch zwei Anlageklassen gibt: "Deutsche und US-Staatsanleihen" und den Rest. Ein bißchen überspitzt, aber soll sagen: In Panikmomenten gibt es nur noch Sachen, die als risikoarm betrachtet werden und Dinge, die - vollkommen undifferenziert als riskant gelten."

Naja, wenn dich die Krise 08 speziell interessiert, kannst du mal die Renditen verschiedener Assets in dieser Zeit vergleichen. Aktien sind wie gesagt um so die Hälfte abgerauscht. AAA-Staatsanleihen wie zB die amerikanische Zehnjährige hatten das Jahr tatsächlich noch mit 15-20% Gewinn abgeschlossen. (Nicht verwunderlich eigentlich, wenn man bedenkt wo denn die ganzen Big Player, die in der Krise ihre Billionen aus den Aktien geflüchtet hatten, das Geld nun auch noch parken sollten ?

Auf Bankkonten ja sicher nicht, Staatsanleihen natürlich). Selbst Gold hatte das Jahr noch mit einem kleinen Gewinn beendet.

Das ist natürlich nur die Betrachtung auf Jahresbasis, die einiges verschleiert, wenn man etwas tiefer reinbohrt in die kurzfristigen Volatilitäten und Korrelationen innerhalb dessen gab es auch bei den "sicheren" Assets ein paar verhältnismäßig zitterige Wochen etc. Da wurde eben auch so manches "Risikosystem", das nur auf historisch-langfristigen "Normalzustand"-Annahmen basierte, gerissen.

Wieviel "Undifferenziertheit" da mit im Spiel ist, kommt drauf an wie stark man davon überzeugt ist, dass auch in "normalen" Phasen die Märkte immer alles schön differenziert betrachten.

War der 80% Absturz des Nasdaq von 2000 bis 2003 differenziert ? Nicht unbedingt, aber das war der 300% Anstieg die drei Jahre zuvor ja auch nicht unbedingt.

Im Grunde wechseln sich an den Börsen doch eigentlich immer nur Zyklen mehr oder weniger "positiver" Unvernunft in Rallyes mit Phasen übertriebener Negativität,Verkaufspanik, Crashs ab.

Irgendwo dazwischen gibt es vielleicht einen "gerechtfertigten" Mittelwert, der auch langfristig nach oben zeigt, um den aber kürzerfristig immer nur in der Mean Reversion herumgependelt werden kann.

chaostrader sagt am 05. März 2016

VaR kann eigentlich nur Bullshit sein. Meine Onlinebank bietet eine Depot"optimierung" an, die auf VaR basiert. Da steht dann z.B., dass mein (höchstspekulativer und extremvolatiler?) MSCI World einen "stark erhöhten" Risikobeitrag hat, während so solide Anlagen wie ein gehebelter ETF auf den MSCI USA einen nur "erhöhten" Risikobeitrag liefert. Die beste Anlage ist dann offensichtlich ein ETF auf den Athex (griechischer Aktienindex), weil der ein "neutrales" Risiko liefert. Der ist in den vergangenen Jahren um über 90% abgeschmiert, seit letztem Jahr hat sich der Preis halbiert. Aber gut, dass der einen so tollen VaR hat!

Chris sagt am 08. März 2016

@chaos:

Ich kenn sowas, diese ganzen kostenlosen "Analyse"tools die Onlinebroker so anbieten sind eigentlich für den seriösen, halbwegs professionellen Gebrauch nicht geeignet. Oft sind die schon mit allem, was über Standartaktien hinausgeht, überfordert und spucken entweder nur unsinnige Werte aus oder sagen gleich "kann nicht erkannt werden". Genaus wie auch so manche Angaben zu Fundamentalkennzahlen falsch sind und man lieber gleich die Originalquellen benutzen sollte. Mehr als höchstens ne nette Spielerei ist das nicht, darauf verlassen sollte sich keiner, und wenn man schon quantitative Methoden benutzt muss man eben die Ärmel hochkrempeln und das selbst zusammenprogrammieren, um die Kontrolle über Datenlage und Algorithmen zu bewahren. (Und wenn man dann trotzdem noch Mist baut, war man wenigstens selbst schuld und nicht ein anderer).

Aus diesen schlechten Apps der Anbieter aber gleich zu schlussfolgern das VaR an sich insgesamt nur Bullshit ist, wäre aber auch zu pauschal. Man muss es halt nur selbst machen, konsistente Kurslistendaten der ETFs besorgen, in Excel die richtigen Formeln durchrasseln lassen, dann können schon brauchbare Ergebnisse bei rauskommen. Was du dann im Endeffekt konkret draus machst (also zB eine Allokation nach angestrebtem Ziel-VaR, oder umschichten von "risikoreichere" in "risikoärmere" Anlagen etc.), bleibt ja immer noch dir selbst überlassen. Wer daran Spaß hat und gerne das Verhalten seines Portfolios bis in die dritte Nachkommastelle analysieren will, für den sind solche Sachen ganz interessant. Wer generell keinen Nerv für Zahlenkram hat (was nützt es ja auch zu wissen, wieviel VaR ein Portfolio hat wenn man eh nichts daran ändern will), brauch sich das auch nicht unbedingt antun und kann sich auch einigermaßen gut an leichter verständliche "Laienregeln" (wie zB 50%-Crashtest=Aktienquote, oder die 100 minus Lebensalter Allokation etc) halten, ohne deswegen gleich megaviel zu verpassen. Gibt ja auch weniger komplexe Strategien wie zB Dualmom, für die man nicht groß rechnen muss. ;-)

Erik Podzuweit, Mitgründer Scalable Capital sagt am 10. März 2016

Hallo Finanzwesir, liebe Community

Bitte entschuldigt den sehr umfangreichen Post. Der Umfang schien mir angebracht, da es im Artikel und der Diskussion nicht nur um VaR, sondern generell um das wichtige Thema der Messung von Risiken bei der Geldanlage geht.

Da ich unten sehr ausführlich Stellung zum Thema nehme, vorab die wichtigsten Punkte in der Übersicht:

• Vale-at-Risk ist ein Risikomaß, kein Modell, so dass Fehler in der Modellierung nicht die „Schuld“ der Maßeinheit sind – so wie Fehler in der Temperaturmessung nicht die Schuld der Maßeinheit Grad Celsius sind.

• Value-at-Risk ist für lineare Anlageinstrumente wie Aktien- oder Anleihen, trotz bestimmter Nachteile, das unter den Downside-Risikomaßen am besten geeignete.

• Für eine gute Risikosteuerung können bei der Berechnung des VaR „Fat Tails“ bzw. „schwarze Schwäne“ nicht nur berücksichtigt werden – sondern müssen dies sogar. Dies ist analytisch nicht lösbar, sondern erfordert aufwändige Simulationsrechnungen.

• Und zuletzt noch eine Verteidigung in eigener Sache: der Anlageprozess von Scalable Capital basiert auf einer sorgfältigen Umsetzung empirisch fundierter, wissenschaftlicher Ergebnissen, die von Forschern mit internationaler Reputation stammen. Ihre Arbeiten „pseudo-wissenschaftlich“ zu nennen, darf zumindest als gewagt bezeichnet werden.

Das perfekte Risikomaß?

Grundsätzlich vorab: es gibt es kein singuläres Risikomaß, das die Risiken einer Anlage vollständig erfasst!

Für eine voll umfängliche Risikobeschreibung muss die komplette Verteilungsfunktion des Werts der Anlage am Ende des Anlagehorizonts bekannt sein. Eine Verteilungsfunktion gibt an, mit welchen Wahrscheinlichkeiten beliebige Renditeintervalle erreicht werden. Noch schwieriger ist der Fall, wenn der Anlagehorizont nicht fest vorgegeben, sondern offen ist. Dann muss die Evolution der Verteilungsfunktion im Zeitablauf bekannt sein.

Aus mindestens drei Gründen tauchen jedoch Verteilungsfunktionen in der Anlageberatung quasi nie auf:

- die wenigsten Anlageberater verstehen das Konzept der Verteilungsfunktion,

- die Bestimmung realistischer, künftiger Verteilungsfunktionen ist schwierig und kann höchstens in Form von Approximationen geschehen,

- da im Prinzip unendlich viele Renditekonstellationen betrachtet werden können, kann der Anleger letztlich mit einer unendlichen Zahlenflut konfrontiert sein, womit ihm bei einer Risikoabwägung auch nicht geholfen ist.

Daher ist es in der Anlageberatung üblich, mit spezifischen Risikokennzahlen und nicht mit Verteilungsfunktionen zu arbeiten. Wäre allerding die Verteilungsfunktion bekannt, könnten alle beliebigen Performance- oder Risikokennzahlen davon abgeleitet werden.

Es gibt ein breites Spektrum an Risikokennzahlen, und jede hat Vor- und Nachteile. Im Blogartikel wird dankenswerterweise die Risikokennzahl VaR sorgfältig definiert und anhand von Beispielen illustriert. Das gelingt in der Praxis den wenigsten Beratern.

VaR ist eine Maßeinheit, kein Modell.

Wichtig ist auch, die Nachteile des VaR zu verdeutlichen. Allerdings gerät im Artikel dabei einiges durcheinander. Mal wird von „VaR“, mal von einem „Modell“ gesprochen. Hier muss man sauber trennen. „VaR“ ist eine Maßeinheit für Risiko, vergleichbar etwa zu Grad Celsius als Maßeinheit für Temperatur. Ein „Modell“ ist etwas, mit dem man versucht, eine unbekannte Größe anhand bekannter Größen zu bestimmen. Im Fall von Temperatur könnte das die Oberflächentemperatur des Mars sein. Liegt meine Bestimmung für die Marstemperatur weit daneben, dann ist es nicht die Schuld der Maßeinheit Grad Celsius, sondern liegt entweder an falschen Modellannahmen, Rechenfehlern oder beidem.

Kritik an einer Anlagemethode sollte daher immer am Modell und seinen Annahmen geübt werden – nicht an der Output-Größe.

Vor- und Nachteile von VaR und Alternativen Risikomaßen.

Wie gesagt, es gibt eine große Auswahl an Kenngrößen, und die gängigste, die Volatilität bzw. Standardabweichung der Anlagerendite, ist vielleicht die mit dem geringsten Informationsgehalt. Sie hat den Nachteil, dass sie schwer zu interpretieren ist und dass positive und negative Abweichungen gleichermaßen einfließen und diese dabei gemittelt werden. Volatilität ist immer dann unangebracht, wenn, wie es in der Praxis tatsächlich der Fall ist, positive und negative Abweichungen sich in Frequenz und Ausmaß unterschiedlich verhalten. Daher hatte sich schon Andrew Roy 1952 (zeitgleich mit Harry Markowitz) Gedanken darüber gemacht, wie man explizit Verlustrisiken in Allokationsentscheidungen einbeziehen kann. Ab Mitte der 1970er Jahre begann auch die wissenschaftliche Literatur zu dieser Fragestellung zart zu sprießen, und seit den 1990er Jahren fand der Gedanke, Verlustrisiken zu betrachten, breiteren Eingang in die Finanzpraxis und die Regulierung. Dabei stand zunächst der VaR im Mittelpunkt. Inzwischen hat sich das Arsenal an Verlust- oder sogenannten Downside-Risk-Maßen aber erweitert, so dass Größen wie „Expected Shortfall“ (ES) oder „negative Semi-Varianz“ (NSV) Anwendung finden. Alle drei - VaR, ES und NSV - sind Spezialfälle des sogenannten „Lower-Partial-Moment“-Konzepts, das im Prinzip eine Art „Mutter aller Verlustmaße“ darstellt.

Was sind nun die Vor- und Nachteile des VaR? Der VaR mit Konfidenzniveau (1-alpha) beschreibt nichts anderes als das alpha-Quantil einer Verteilung. Beträgt alpha 5%, dann entspricht der VaR-Wert dem Schwellenwert, so dass wir erwarten, mit 95%iger Wahrscheinlichkeit über diesem Wert zu liegen und mit 5%iger Wahrscheinlichkeit darunter. Der Wert sagt nichts darüber aus, was genau über- oder unterhalb des Schwellenwertes passieren kann.

Werden dadurch Risiken verschleiert?

"Value at Risk verschafft Investment-Managern die Möglichkeit, Risiken in enormen Umfang zu verstecken. Gerade bei komplexen Finanzprodukten geht das sehr einfach."

Unter Umständen ist das tatsächlich der Fall. Z.B. dann, wenn es sich um komplexe Finanzinstrumente, wie z.B. (einfache, Barrier-, Knock-out-, Lookback- etc.) Optionen handelt. Wir sprechen hier von „nichtlinearen“ Finanzinstrumenten. Diese sind in Handelsbüchern von Banken typischerweise zuhauf anzutreffen, und das von Frank Riedel angeführte Zitat

"Solange eine Bank über Value at Risk eine beliebige Menge an Risiken verbergen kann, ist es völlig egal, ob sie eine Eigenkapitalquote von 8 Prozent oder von 30 Prozent hat."

Prof. Dr. Frank Riedel vom Institut für mathematische Wirtschaftsforschung in Bielefeld

bezieht sich genau auf diesen Fall. Bei Portfolios mit nichtlinearen Instrumenten wäre es sehr kritisch, die Risikomessungen auf ein einziges Quantil zu beschränken. Aber auch jedes andere, singuläre Risikomaß stößt hier an seine Grenzen. Was würde uns in diesem Fall z.B. die Information „die Volatilität beträgt 60%“ sagen? Bei nichtlinearen Instrumenten ist in der Tat die Verteilungsfunktion gefragt.

Der VaR kann auch bei einfachen, linearen Instrumenten (wie z.B. Aktien oder Aktien-, Anleihe- Rohstofffonds etc.) zu Fehleinschätzungen führen. Z.B. wenn die Renditeverteilung „Fat Tails“ hat (einfach gesagt: große Ausschläge treten mit einer überhöhten Wahrscheinlichkeit auf) und dies bei der VaR-Berechnung NICHT berücksichtigt wird. Hier sind wir aber bei dem Problem der Modellierung bzw. der falschen Modellannahmen und nicht mehr bei der Frage des Risikomaßes.

Um Informationen „beyond VaR“ zu berücksichtigen, kann zusätzlich der Expected Shortfall (ES) verwendet werden. ES ist definiert als der Durchschnittsverlust, der eintritt, wenn die VaR-Schwelle verletzt wird, und somit über die VaR-Schwelle hinaus. ES hat zudem einen theoretischen Vorteil. Nichtlineare Instrumente können dazu führen, dass das VaR-Maß Portfoliorisiken überschätzt, da es nicht „subadditiv“ ist. Ein Überschätzen von aufgrund von „Superadditivität“ ist beim ES nicht möglich. Ob es wichtiger ist, Risiken nicht zu über- oder nicht zu unterschätzen, ist allerdings eine Frage der Risikoaversion des Anlegers.

Zwar schaut ES über die VaR-Schwelle hinaus, hat aber kurioserweise hat den Nachteil, dass er genau dann (mathematisch) nicht existiert, wenn die Tails der Verteilung besonders „fat“ sind, also wenn die Verlustrisiken besonders extrem sind. Quantile, und somit VaR, existieren immer, unabhängig davon, mit welcher Renditeverteilung wir es zu tun haben.

Existiert der ES und haben wir es – wie bei ETF Portfolios – mit linearen Instrumenten zu tun, dann stehen VaR und ES in einer Relation der Art: ES = (1+X)*VaR, wobei der Wert von X>0 von der „Fat Tailedness“ der Anlageverteilung abhängt: je extremer, desto größer ist X. Mit anderen Worten: Kann ich das Tail-Verhalten in etwa abschätzen, so kann ich auch X (analytisch oder simulationsgestützt) abschätzen und von ES auf VaR bzw. umgekehrt von VaR auf ES schließen. Folglich sind VaR und ES bei linearen Universen kompatibel und führen zu äquivalenten Allokations-Entscheidungen.

Verschiedene Studien, wie z.B. die von Danielsson, Jorgensen, Mandira, Samorodnitsky und de Vries (“Subadditivity Re-examined: The Case for Value-at-Risk”, 2005, Financial Markets Group, London School of Economics), zeigen in der Tat, dass bei linearen Instrumenten VaR ein adäquates Risikomaß ist.

Das größte und für die Anlagepraxis besonders relevante Handicap von ES ist, dass die Validierung von rein ES-basierten Risikomodellen nicht möglich ist. Mit anderen Worten: Man kann die Tauglichkeit des Risikomodells ex ante nicht beurteilen, der Anleger muss blind vertrauen. Paul Embrechts, einer der renommiertesten Wissenschaftler auf dem Gebiet der Finanzmarkt- und Risikoforschung, sagte 2013: „If you held a gun to my head and said: ‘We have to decide by the end of the day if Basel 3.5 should move to ES, with everything we know now, or do we stick with VaR’, I would say: ‘Stick with VaR’ “.

Das Urteil aus der Praxis fällt ähnlich aus. David Viniar, ehemaliger CFO von Goldman Sachs, der aufgrund der prognostizierten VaR-Verletzungen der Handelsbücher bereits in 2007 die Entscheidung traf, die Risiken der Mortgage Bücher zu reduzieren, meint: “VaR is a useful tool. The more liquid the asset, the better the tool. The more history, the better the tool. The less of both, the worse it is.“

VaR und Fat-Black-Swan-Tails.

Wie steht es um folgende Aussagen?

"VaR ist ein Schönwetter-Risikomaß, denn was bei einem Extremereignis passiert, ist nicht Teil des Modells. Aber genau dieser Bereich ist für uns als Anleger besonders wichtig.

Value at Risk ist nicht "schwarzer-Schwan-sicher"

Was ist ein Extremereignis? In der Statistik wird von Extremereignissen immer nur mit Bezug auf ein gegebenes Referenzmodell gesprochen. Gehe ich von der Durchschnittsgröße eines Bewohners Westeuropas aus, ist jeder Säugling ein Ausreißer. Glaube ich z.B., dass die Kursänderungen des Dow Jones-Index normalverteilt sind, dann ist ein Tagesverlust von 5% ein Extremereignis, das nur einmal in rund 1000 Jahren vorkommen sollte. Schauen wir auf die 120-jährige Geschichte des Index, kommen derartige Verluste aber im Mittel alle 18 Monate vor. Da überrascht es nicht, dass „Otto Normalanleger“ glaubt, schwarze Schwänen flögen scharenweise umher. Trifft man eine realistischere Verteilungsannahme, wie z.B. die von Benoit Mandelbrot vorgeschlagene „stabile Verteilung“, die Fat Tails und Asymmetrien in den Renditen berücksichtigt, ist ein 5%iger oder 10%iger Tagesverlust keine Überraschung. Derartige Verluste treten im Mittel halt etwa alle 18 Monate bzw. 25 Jahre auf, und das Modell rechnet damit. Mehr dazu ist z.B. in Rachev und Mittnik, Stable Paretian Models in Finance, Wiley, 2000, nachzulesen.

Aber sollen wir uns bei Anlageentscheidungen maßgeblich an der Möglichkeit extremer Verluste orientieren? Sollte ich beim Autokauf darauf bestehen, dass ich auch Extremunfälle unbeschadet überstehe? Nehmen wir an, ich stehe am Ende eines Staus auf der Autobahn. Ein denkbares Extremereignis wäre, dass ein 40-Tonner ungebremst mit voller Geschwindigkeit auffährt. Wie muss mein Auto konstruiert sein, damit ich das mit möglichst wenigen Blessuren überstehe? Was würde ein derartiges Auto kosten? Wie würde die Ökobilanz aussehen, wenn alle Autofahrer dieses Sicherheitsbedürfnis hätten?

Auch bei der Konstruktion eines Anlageportfolios ist es nicht ratsam, immer nur Worst-Case-Szenarios vor Augen zu haben. Wähle ich immer das Portfolio, das selbst in der verlustreichsten Marktphase die geringste Einbuße erleidet, dann bleibt mir in der Tat nur das Sparbuch.

Sagt VaR nichts über das „Wann“ aus?

"Value at Risk sagt nichts über das "Wann" aus

Das VaR-Modell gibt auch keine Auskunft über die Periodizität. In unserem Beispiel bedeutet das: Die Kurse der Schwellenland-Aktien können 23 Jahre und neun Monate steigen und in den letzten 15 Monaten geht es dann jeden Monat um mindestens 12,11% nach unten."

Natürlich tut es das nicht. Sagt Grad Celsius etwas darüber aus, welche Temperatur in sechs Wochen um 14 Uhr in Frankfurt herrschen wird? VaR ist ein Risikomaß, kein Prognosemodell.

Interessanterweise lassen sich aber Finanzmarktrisiken – im Gegensatz zur Kursentwicklung – überraschend gut prognostizieren. Empfehlenswert ist, hier nicht an verlässliche Periodizitäten oder Zyklen (à la Elliot-Wellen) zu glauben, sondern lieber fundierte wissenschaftliche Erkenntnisse der Risikoforschung heranzuziehen. Die Arbeiten von Robert Engle (der dafür 2003 mit dem Nobel-Gedächtnispreis ausgezeichnet wurde) und seinen Schülern waren ebenso bahnbrechend wie die von Markowitz. Weiterentwicklungen seiner Methoden eignen sich dazu, risikogerechte, auf Risikoprojektionen basierende Allokationsentscheidungen zu treffen.

Das obige Zitat greift jedoch einen wichtigen Aspekt auf: Kann es tatsächlich passieren, dass ich 23 Jahre und neun Monate die VaR-Schranke nicht verletze, dann aber 15 Monate in Folge VaR-Verletzungen auftreten? Ja, das kann dann der Fall sein, wenn man sich auf naive Modelle zur Risikoprognose beschränkt und Risikodynamiken außer Acht lässt. Die Existenz dynamischer Risikostrukturen an Finanzmärkten ist unbestritten: Es gibt alternierende Phasen hoher und niedriger Volatilität, auch „Volatility Clustering“ genannt. Wird dies bei der VaR-Modellierung ignoriert oder fehlerhaft berücksichtigt, dann kommt es unweigerlich auch zum einem „Violation Clustering“, also aufeinanderfolgenden Verletzung von VaR-Schranken.

Bei der Risikoquantifizierung wird daher unterschieden, ob es sich um eine sogenannte „unbedingte“ oder„bedingte“ Herleitung handelt. Dem entsprechend unterscheidet man zwischen „unconditional“ (unbedingten) und „conditional“ (bedingten) Kenngrößen, also dem „Unconditional VaR“ (bzw. einfach nur VaR) und dem „Conditional VaR“ bzw. dem „Unconditional ES“ (bzw. einfach nur ES) und dem „Conditional ES“ (wobei Praktiker häufig den „Unconditional ES“ als „Conditional VaR“ bezeichnen). Die „bedingte“ Schätzung zieht möglichst alle aktuell relevanten Informationen (man spricht von der „Informationsmenge“) in den Quantifizierungsprozess ein, während die unbedingte Schätzung sich typischerweise an historischen Durchschnittswerten orientiert. Z.B. könnte ich bei der Entscheidung, ob ich zum Spazierengehen einen Regenschirm mitnehmen soll oder nicht, anhand der 100-jährigen Wetteraufzeichnung die durchschnittliche Regenwahrscheinlichkeit für den heutigen Kalendertag und meinen Wohnort bestimmen. Das wäre eine „unbedingte“ Schätzung der Regenwahrscheinlichkeit. Alternativ oder zusätzlich könnte ich auch aus dem Fenster schauen und die Wolkenlage in Augenschein nehmen, um zu beurteilen, ob ein Schirm angeraten ist oder nicht. Das wäre eine „bedingte“ Schätzung.

Auch bei der Prognose von Anlagerisiken sollte beherzigt werden, dass aktuelle Marktinformationen besonders dienlich sind, und die ausschließliche Betrachtung von Durchschnittswerten aus langen, historischen Zeiträumen nicht genügt. Analog zu unbedingten und bedingten Risikokenngrößen gibt es auch unbedingte und bedingte Renditeverteilungen. Allokationsentscheidungen sollten deshalb auf bedingt prognostizierten Renditeverteilungen basieren, die via Monte-Carlo-Simulationen approximiert werden. Die Simulationen müssen zugrundeliegende Modelle, Risikodynamiken, Asymmetrien und Fat Tails berücksichtigen, sowie das komplexe Zusammenspiel verschiedener Assetklassen, das nicht durch einfache Pearson-Korrelationen erfasst werden kann. Mittels dieser approximierten bedingten Verteilungen kann jede gewünschte, bedingte Kenngröße approximiert werden. Klar, es handelt sich stets um bedingte Approximationen. Diese sind aber für risikogerechte Anlageentscheidungen eindeutig zielführender als naive Durchschnittsbetrachtungen.

Wie kann man beurteilen, ob ein Risikoprognosemodell adäquat ist oder tatsächlich 15 VaR-Verletzungen in Folge zu fürchten sind? Im Wesentlichen können zwei Dinge bei der VaR-Prognose schief laufen:

-

Die VaR-Prognose wird viel häufiger (viel seltener) verletzt als die erwarteten alpha Prozent. In diesem Fall versagt das Modell hinsichtlich der sogenannten „Unconditional Coverage“, d.h. es kommt zu exzessiven „Coverage Violations“. Hier ist die fehlerhafte Berücksichtigung der Risikodynamik und/oder der Fat Tailedness der bedingten Verteilung das Problem.

- Obwohl die Unconditional Coverage hält, könnten die VaR-Prognosen viele Perioden hintereinander (z.B. 15 Monate) überschritten werden. Man spricht hier von einer „Independence Violation“. Die VaR-Verletzungen sollten idealerweise über die Zeit statistisch unabhängig sein. Ist dies nicht der Fall, dann „lernt“ das Modell nicht oder nicht richtig von seinen Fehlprognosen.

Es gibt statistische Testverfahren, mit denen wir prüfen können, ob ein Risikoprognosemodell Defizite hinsichtlich Problem 1 (Unconditional Coverage), Problem 2 (Indepencence) oder beider Probleme (Conditional Coverage) hat. Siehe z.B. Christoffersen und Pelletier („Backtesting value-at-risk: A duration-based approach”, Journal of Financial Econometrics, 2004) oder Candelon, Colletaz, Hurlin, und Tokpavi („Backtesting Value-at-Risk: A GMM duration-based test“, Journal of Financial Econometrics, 2011) zu derartigen Testverfahren. Die Ergebnisse in Kuester, Mittnik und Paolella („Value-at-Risk Prediction: A Comparison of Alternative Strategies“, Journal of Financial Econometrics, 2006) und vielen anderen Studien zeigen, dass es sinnvolle Risikoprognosemodelle gibt, die die Güte von VaR-Prognosen erheblich verbessern.

VaR und Anlagedauer.

Mit der Aussage

"Die VaR-Berechnung wurde für eine Haltedauer von einem Tag entwickelt, nicht für die normalen Anleger mit einem Anlagehorizont von 5 bis vielleicht 30 Jahren."

wird ein weiterer neuralgischer Punkt der Risikomodellierung angesprochen: Wie kann man mit hochfrequenten Daten (z.B. mit Tages-, Wochen- oder Monatsdaten) Risikoprognosen für ein Jahr oder länger herleiten? Die Schwierigkeiten, die dabei entstehen, sind auch der europäischen Regulierungsbehörde für die Versicherungswirtschaft (EIOPA) zum Verhängnis geworden (siehe Mittnik, „Solvency II Calibrations: Where Curiosity Meets Spuriosity“, Center for Quantitative Risk Analysis, 2011). Krude Extrapolationsstrategien nach der sogenannten „Wurzel-T“-Regel funktionieren nur dann, wenn Renditen normalverteilt sind und zudem über die Zeit unabhängig sind. Beides trifft für Finanzdaten nicht zu, sodass man in Ermangelung analytischer Lösungen gezwungen ist, auf Simulationstechniken zurückzugreifen.

Ist VaR nur etwas für Daytrader?

"Hier werden Langfristanleger mit Instrumenten bedient, die eigentlich für Daytrader gedacht sind."

Der VaR für ein gegebenes Konfidenzniveau ist einfach das Quantil einer Verteilung. Ob es sich dabei um Minuten-, Tage- oder Monatsrenditen handelt, ist dem Quantil völlig egal. Das Problem ist aber, dass ich bei sehr hohen Konfidenzniveaus (sprich: sehr kleinen alpha-Werten), entweder viele (sprich: hochfrequente) Daten brauche, um das Quantil verlässlich empirisch zu bestimmen, oder entsprechende Modellannahmen treffen muss. Daher machen Risikomodelle, die auf Konfidenzniveaus von 99% oder höher basieren, oft keinen Sinn. Sie erfordern entsprechend hochfrequente Daten (z.B. täglich oder gar stündlich) und liefern Information, die dann irgendwie auf einen langfristigen Prognosehorizont „hochgerechnet“ werden muss.

Hohe Konfidenzniveaus erschweren zudem erheblich die Validierung von Risikomodellen, da u.U. viele Jahre benötigt werden, um eine aussagekräftige Anzahl von VaR-Verletzungen zu realisieren, die zu einer verlässlichen Prüfung der Modelladäquanz erforderlich sind. Neben modelltechnischen Gründen ist noch wichtiger, dass eine Verletzung der Verlustschranke, die im Mittel alle 20 Jahre auftreten soll, für den Anleger eher begreifbar ist als eine Verletzung, die einmal in 100 Jahren auftritt.

Fazit.

Damit bin ich beim Fazit des Blogartikels angelangt:

"Nur mit Value at Risk lässt sich kein Depot sinnvoll absichern."

Hier wäre zu klären, was mit „absichern“ gemeint ist. Absolute Verlustvermeidung? Nur „moderate“ Verluste zulassen? Oder halb so viel wie bei einer Buy & Hold-Strategie, bei der Absicherung erst gar kein Thema ist? Bei Scalable Capital werden dem Anleger bei der Risikoeinstufung konkrete Verlusthöhen mit einem Konfidenzniveau von 95% zur Auswahl gegeben. In die Risikomodellierung selbst fließen dann zusätzlich zum (Conditional) VaR auch andere Größen, wie Conditional ES, bedingte Volatilität oder der historische Maximalverlust ein, um so zu möglich robusten Entscheidungen zu gelangen.

"Lassen Sie sich nicht einwickeln von listigen Verkaufsfüchsen, die ihnen mit pseudo-wissenschaftlichen Begründungen das Geld aus der Tasche ziehen wollen."

Unser Anlageprozess basiert auf wissenschaftlichen Ergebnissen, die weit über die epochale Arbeit von Harry Markowitz hinausgehen. Diverse Forscher, deren Ergebnisse in unseren Prozess eingeflossen sind, habe ich oben namentlich aufgeführt. In Fachkreisen genießen sie alle einen exzellenten Ruf. Zu behaupten, dass es sich bei diesen Forschern um „Pseudo-Wissenschaftler“ handelt bzw. dass die Begründungen für ihre Forschungsergebnisse „pseudo-wissenschaftlich“ seien, erscheint mir recht gewagt.

Diese neueren wissenschaftlichen Ergebnisse sind zweifellos wichtig für den erfolgreichen Vermögensaufbau, und wir haben uns größte Mühe gegeben, diese zum Nutzen des Anlegers operational umzusetzen.

Beste Grüße

Erik Podzuweit

Gründer von Scalable Capital

Christoph (der Stillhalter) sagt am 11. März 2016

@Erik Podzuweit, Mitgründer Scalable Capital: Ich habe mir das jetzt durchgelesen, habe mir dann euer dynamisches Risikomanagement und euer Anlageuniversum und den ganzen Rest angeschaut. Festgestellt habe ich dann, dass ich jetzt genau so viel über euren Mehrwert weiß wie vorher auch - nämlich gar nichts.

Jetzt musst du zuerst wissen, dass ich das bin was man wohl am besten als hemdsärmeliges Frontschwein beschreibt. Ich mag kein Bullsh*t-Bingo und setze in Windeseile Sachen um für die andere fünfmal so lange brauchen. Gleichzeitig umgebe ich mich geschäftlich aber am liebsten nur mit Leuten, die sehr viel mehr auf dem Kasten haben als ich selbst.

Mehr auf dem Kasten als ich habt ihr ohne jeden Zweifel. Aber das kommt dann dabei raus? STOXX Europe, Core Dax, S&P 500 und mein persönlicher "Favorit" Dow Jones Asia Pacific Select Dividend 30? Also eine Lösung, die ich Börsen-Dämlack in 5 Minuten selbst ins Depot zaubern kann? Und dann soll ich laufend raus aus den Kartoffeln und wieder rein in die Kartoffeln weil eure Simulationen etwas vorhersagen, das sie eigentlich gar nicht richtig vorhersagen können?

Für mich ist das ungefähr so als würde ich einen Vortrag über die neuesten wissenschaftlichen Erkenntnisse und das Risikomanagement in der außerklinischen Wundversorgung halten, den selbst praktizierende Ärzte kaum verstehen können um dann zum Schluss folgendes zu sagen: "Wenn Sie uns Ihre Wundversorgung anvertrauen, desinfizieren wir die Wunde mit einem geeigneten Desinfektionsmittel und verbinden sie mit einer Mullbinde. Dann geben wir einen Tropfen Arnica-Extrakt auf einen Ozean voller Wasser, verarbeiten das Gemisch zu Zuckerkügelchen und verabreichen Ihnen diese Kügelchen in gewissen zeitlichen Abständen oral. Zögern Sie nicht und profitieren Sie mit uns noch heute von den neuesten wissenschaftlichen Erkenntnissen aus der medizinischen Forschung".

Vielleicht noch etwas zum Hintergrund. Ich bin der Inhaber einer Webagentur, die sich auf Conversion Optimierung, Personalisierung, intelligentes Tracking und so weiter spezialisiert hat. Bei mir sitzen also auch sehr oft Leute, die erfolgreich im Web aktiv sind und daran zweifeln, dass wir da einen großen Unterschied machen können. Wenn die aber dann sehen was wir machen und wie wir das machen fallen sie regelmäßig fast vom Stuhl und sagen dass sie niemals auf solche Lösungen und Gedanken gekommen wären.

Moutard sagt am 11. März 2016

K.I.S.S oder wie war das ?

voll krass eh ! Soviele Wörter - So wenig KLARtext !

P.S.: in diesem Satz:

"der Anlageprozess von ... basiert auf einer sorgfältigen Umsetzung empirisch fundierter, wissenschaftlicher Ergebnissen, die von Forschern mit internationaler Reputation stammen." fehlt vielleicht nur noch der Hinweis auf ein "Abfallprodukt der Weltraumtechnik". Dann ist man der Held beim nächsten Smalltalk im Club.

Erik, Scalable Capital sagt am 15. März 2016

Hallo Phoenix,

Vielen Dank!

Zu Deiner Frage "Warum kann ich Risiko recht gut vorhersagen? Wie soll das konkret gehen?”

Kurzantwort:

Aufgrund von Volatility Clustering.

Risiken treten nicht rein zufällig sondern in Gruppen auf. Es gibt Phasen hoher und niedriger Risiken, die zeitlich voneinander abhängen (man spricht hier auch von Autokorrelation, d.h. die Risiken korrelieren untereinander).

Wenn es heute oder diesen Monat überdurchschnittlich stark schwankt (z.B. DAX Tagesbewegungen von 5%), dann ist die Wahrscheinlichkeit, dass es morgen und nächsten Monat auch überdurchschnittlich turbulent ist, erhöht.

Die Wahrscheinlichkeit ist nicht 1, aber sie ist besser als der Münzwurf.

Der Endecker des Phänomens, Benoit Mandelbrot, beschreibt dies so: "large changes tend to be followed by large changes and small changes tend to be followed by small changes”

Wie kann man das nutzen?

Da Phasen stark erhöhter Risiken in der Regel mit negativen Risikoprämien einhergehen, kann man bessere risikoadjustierte Renditen erwirtschaften, wenn man es (z.B. durch ökonometrische Simulationsmodelle) schafft, Phasen hoher Risiken abzumildern / etwas zu umschiffen. Sprich: in Niedrig-Risikophasen will ich auf dem Weg nach oben einfach mit dem Markt partizipieren, da bringt es nichts hin und her zu traden. In Hoch-Risikophasen will ich nicht den vollen Abschwung mitnehmen und Vola Clustering gibt mir hier eine Möglichkeit, diese zu erkennen.

Die Methode nennt sich Risk-Targeting und erwirtschaftet langfristig bessere Sharpe-Ratios (SR von ca. 0,5-0,6 vs. Buy&Hold von 0,2-0,3).

Gruß

Erik

WiMi sagt am 16. März 2016

Sehr sehr spannend das Konzept von Scalable.

Ich bin wirklich geneigt das mal auszuprobieren nur aus Interesse was dann mit meinem Portfolio in kleineren Krisen passiert.

Ich konnte die kleineren Korrekturen der Aktienmärkte der letzten Monate für Nachkäufe nutzen. Nach Daniel Kahnemann (Regression zum Mittelwert) würde ich sagen, damit ist ein leichtes Market Timing für buy-and-hold-Anleger sehr wohl möglich ist.

Jetzt frage ich mich natürlich ob man mit dem Algorithmus von Scalable ein besseres Verhalten erreicht. Ich habe (leider ohne Quelle) mal gelesen, dass die eigentliche Performance der Aktienmärkte nur an wenigen Tagen im Jahr zustandekommt. Sind das die Phasen mit geringer Volatilität, oder kann es sein, dass man diese verpasst, wenn man dann eben raus ist, weil gerade "die Kanonen donnern"?

Da der Algorithmus sehr komplex ist, kann ich das Verhalten natürlich nicht nachvollziehen.

Was ist bei Deflation oder bei Hyperinflation? Ich arbeite beruflich mit robuster Optimierung von Steuertrajektorien und weiß, dass man manchmal Sachen passieren, die nicht im Modell stecken und man deshalb immer ein Auge darauf haben muss, was das Modell berechnet und ob das noch gültig ist.

Die Probleme rechtlichen Probleme mit der angabe von Musterportfolios wurden ja schon mal angesprochen, aber vielleicht könnte man ja ein kleines Backtesting-Beispiel von 2006 bis 2010 machen, wo der Finanzwesir seine Performance mit einer anonymen Risikoallokationssoftware vergleicht. ;-)

Vielleicht auch die anderen maximum Drawndown szenarien des Finanzwesirs mit ein paar guten folgenden Jahren.

Allgemein ist ja in allen Anlageklassen nicht mehr so viel zu holen, nach dem was wir so gesehen haben, oder seht ihr das anders? Inwieweit werden solche Fundamentaldaten bei scalable mit berücksichtigt?

http://think-beyondtheobvious.com/stelters-lektuere/erwartete-renditen-negativ-egal-wie-man-es-betrachtet/

http://think-beyondtheobvious.com/stelters-lektuere/welche-renditeerwartung-ist-realistisch/

Ich bin gespannt weiter von euch zu hören.

Phoenix sagt am 16. März 2016

Hm...

Ich habe das jetzt so verstanden:

Keiner kann vorhersagen, ob die Kurse in den nächsten Wochen rauf oder runter gehen. Ok, stimme ich zu. Ihr behauptet (bzw. zitiert Forschungen) jetzt aber, ihr könnt "vorhersagen" (bzw. wahrscheinlicher behaupten), dass es in den nächsten Wochen viel schwanken wird. Ok, lasse ich mir ja auch noch gefallen.

Aber woraus folgt denn jetzt, dass es schwankend nach unten geht? Es könnte doch auch schwankend nach oben und dann bin ich nicht dabei. Wenn wenn ihr sagt "Wir wissen (im gewissen Rahmen, exakte Sicherheit gibt es nicht, usw.) es wird die nächsten Wochen viel schwanken, also wird es nach unten gehen", sagt ihr im Endeffekt doch trotzdem nur "Wir wissen, es wird nach unten gehen". Da ändert doch der Zwischenschritt nichts dran.

Woher dieser Zusammenhang: Es schwankt viel => Es geht nach unten? Wer sagt, dass es nicht doch volatil nach oben geht?

Finanzwesir sagt am 16. März 2016

Hallo Erik,

auch wenn das Tippen auf dem Pad keinen Spass macht und die WLAN-Verbindung fadendünn ist, eine Frage habe ich doch: Es mag ja sein, das institutionelle Anleger die von Dir beschriebenen Effekte ausnutzen können und so eine Performanceverbesserung erzielen.

Aber was kommt bei mir davon an, nachdem ihr eure Gebühren abgezogen habt? Für 0;2% Überperformance bewege ich mich nicht.

Gruss

Finanzwesir

Christoph (der Stillhalter) sagt am 16. März 2016

@ Erik

"Da Phasen stark erhöhter Risiken in der Regel mit negativen Risikoprämien einhergehen, kann man bessere risikoadjustierte Renditen erwirtschaften, wenn man es (z.B. durch ökonometrische Simulationsmodelle) schafft, Phasen hoher Risiken abzumildern / etwas zu umschiffen."

Da ich anscheinend wirklich zu dämlich bin, frage ich jetzt einfach mal gerade heraus:

-

Wenn ich euch 100.000 Euro rüber schiebe mit der Bitte das Geld möglichst chancenorientiert anzulegen und dann am gleichen Tag zu den gleichen Kursen ein identisches Depot bei einer Direktbank anlege und 20 Jahre warte, schlagt ihr dann mein B&H Depot nach Kosten?

- Egal ob Frage eins mit ja oder nein beantwortet wurde, wie sieht diese "risikoadjustierte Rendite" langfristig gegenüber der Marktrendite aus? Ihr habt ja sicher Backtesting betrieben. Ich wüsste das gerne für ein maximal chancenorientiertes Portfolio.

Dummerchen sagt am 16. März 2016

Hallo Phoenix,

ich sehe, da tickt jemand intuitiv erstmal genauso wie ich. Diesen Aspekt "Heißt Schwankung denn immer es geht nach unten?" hatte ich beim u.a. Fintech-Artikel auch schon mal mit Erik (und anderen schlauen Kommentatoren) andiskutiert:

http://www.finanzwesir.com/blog/robo-advisor-fintech-anlageberatung (Kommentare ab 09.11.15)

Chris verweist dort in seinem Kommentar darauf, dass Volatilität insbesondere mit fallenden Kursen zusammenhängt und hat ein paar Links angehängt.

Vielleicht schaust Du Dir die entsprechende Diskussion mal an.

Gruß

Dummerchen

Erik, Scalable Capital sagt am 17. März 2016

Hallo WiMi, Phoenix, Christoph (der Stillhalter),

Danke für Eure Fragen, anbei meine Antworten:

„WiMi: Jetzt frage ich mich natürlich ob man mit dem Algorithmus von Scalable ein besseres Verhalten erreicht. Ich habe (leider ohne Quelle) mal gelesen, dass die eigentliche Performance der Aktienmärkte nur an wenigen Tagen im Jahr zustandekommt.“

Das trifft durchaus zu - allerding sowohl für negative als auch positive Performance.

„Sind das die Phasen mit geringer Volatilität, oder kann es sein, dass man diese verpasst, wenn man dann eben raus ist, weil gerade "die Kanonen donnern"?“

@WiMi, @Phoenix: Starke Kursgewinne finden meist in den ruhigen Phasen statt. Hohe Vola-Level gehen typischerweise mit fallenden DAX-Kursen einher und niedrige bzw. fallende Volas steigenden. Die folgenden Grafiken illustrieren dies anhand des DAX und des VDAX (ein implizites Volatilitäts Maß).

{via Email an Finanzwesir mit der Bitte diese einzufügen}

„Phoenix: Wenn wenn ihr sagt "Wir wissen (im gewissen Rahmen, exakte Sicherheit gibt es nicht, usw.) es wird die nächsten Wochen viel schwanken, also wird es nach unten gehen", sagt ihr im Endeffekt doch trotzdem nur "Wir wissen, es wird nach unten gehen". Da ändert doch der Zwischenschritt nichts dran.”

Interessanterweise macht genau der „Zwischenschritt" einen Unterschied. In der Statistik unterscheidet man zwischen "unbedingten" und "bedingten Prognosen". Dazu folgendes Beispiel:

Ich will in einer Stunde Spazierengehen und frage mich, ob ich einen Regenschirm mitnehmen soll. Weiß ich nur aus der langfristigen Wetteraufzeichnung, dass an meinem Wohnort um diese Jahreszeit eine 30%ige Regenwahrscheinlichkeit, dann ist das eine "unbedingte" Prognose in die keine aktuelle Information einfließt. Schau ich aus dem Fenster und sehe nur grauen Himmel mit dicken Wolken, vermute ich, dass dies vielleicht in einer Stunde auch noch der Fall ist und somit die Regenwahrscheinlichkeit weit über 30% liegen dürfte. Ich "bedinge" mein Prognose auf aktuelle Information und sollte somit genauer prognostizieren können.

Übersetze ich "Wolken" mit "Vola" und "Regen" mit "Kursverlusten" und schaue dann auf die beiden Grafiken oben, dann folgt: Gegeben die aktuelle Vola und die Tatsache, dass die Vola in Clustern auftritt, so kann ich eine Vola-bedingte Prognose machen, die besser als ein Münzwurf ist.

Bedenken muss man allerdings, dass Vola eine Folge von "News Arrival" auf den Märkten ist. Da ich nie weiss wann und in welcher Weise News-induzierte Vola anspringt, kann ich Kurse "unbedingt" nicht prognostizieren. Ist die Vola aber angesprungen, dann sind "bedingte" Prognosen durchaus hilfreich.

@Christoph (der Stillhalter)

- Ja. Es ist unser Ziel (Garantien können natürlich nicht abgegeben werden), bessere risikoadjustierte Rendite zu erwirtschaften. D.h. entweder die gleiche Rendite wie Dein B&H Portfolio zu erwirtschaften, aber dies mit deutlich (ca. halb so hohem) Risiko oder bei gleichem Risiko eine verbesserte Rendite.

- „Maximal chancenorientiert“ wären bei uns Portfolien mit 25% VaR, bei denen wir die Rendite eines breiten, globalen Aktienportfolios anstreben (die in den letzten Jahrzenten Total Return Marktrenditen von ca. 8-10% erwirtschafteten – bei höheren risikolosen Zinsen wohl vermerkt) – aber dies, wie gesagt mit geringeren Schwankungen als die jeweiligen Indizes. So ein globales Aktienportfolio hatte historisch beispielsweise ein Sharpe-Ratio von ca. 0,3 – unser Ziel sind langfristig Sharpe-Ratios von ca. 0,5-0,6.

@Dummerchen, Danke für den Verweis!

Beste Grüße

Erik Podzuweit

chaostrader sagt am 17. März 2016

WiMi, im Forum/Community der Consorsbank wird sowas mit einem 10.000€-Depot praktiziert. Jede Woche wird da seltsam rumgerechnet und dann entschieden, dass man einige Hundert Euro umschichten sollte, es aber nicht macht, weil die Transaktionskosten zu hoch sind. Ich hab da schon lange nicht mehr hingeguckt, sollte mal wieder nachschauen was in den letzten Wochen da passiert ist.

Lorenz sagt am 17. März 2016

Glückwunsch, Finanzwesir! Das ist der beste Finanzblog weit und breit. Man lernt wirklich was, und die DIskussion hier wird mit jeder Iteration besser.

chaostrader sagt am 17. März 2016

WiMi: https://wissen.consorsbank.de/t5/Risikomanagement/bg-p/Risikomanagement

Fürchterlich, was da rumgerechnet und getradet wird, und letztendlich kommt nix bei raus außer Spesen für die Bank.

Chris sagt am 20. März 2016

@Christoph

"Wenn ich euch 100.000 Euro rüber schiebe mit der Bitte das Geld möglichst chancenorientiert anzulegen und dann am gleichen Tag zu den gleichen Kursen ein identisches Depot bei einer Direktbank anlege und 20 Jahre warte, schlagt ihr dann mein B&H Depot nach Kosten?"

Du stellst im Prinzip die richtigen Fragen: Jeder andere Robo, der nur statisches B&H macht, würde immer zwangsläufig schlechter abschneiden als die identische Selbstanlage, da er ja genau das gleiche, nur eben mit Zusatzgebühren macht.

Schwerer zu vergleichen ist es aber, wenn wie hier eben die "einmal identische" Portfolioaufteilung (im Gegensatz zum normalen passiven B&H) nicht ewig bestehen bleibt, sondern öfter mal (nach Risikosystem oder was auch immer) aktiv umgeschichtet wird - das soll ja grad deren vermarktetes Alleinstellungsmerkmal zur Absetzung von der Konkurrenz sein. Auf dieser Seite ( https://de.scalable.capital/dynamisches-risikomanagement/ runterscrollen bis zu der Grafik die so wie "moderne Kunst" aussieht :-D) siehst du mal beispielhaft wie sich die Verschiebung der Anlageklassen-Gewichtungen über die Jahre bewegen kann.

Ob du damit, oder mit B&H "besser" dastehst, ist halt immer Definitionssache. Besser nach Rendite ? Wenn die Aktien jetzt für die nächsten 20 Jahre nur noch schön nach oben gehen, steht man natürlich mit einer 100% Aktien B&H Anlage am besten da. Wenn es doch mal wieder ein paar längere, schwere Crashs gibt, und wenn das Risikosystem die auch gut erkennt (also dich relativ zuverlässig&zeitnah aus Aktien raus, aber dann später auch wieder in Aktien rein bei der Erholung bringt), könntest du mit dieser aktiven Strategie besser fahren.

Und wenn dir im letzten Satz zuviele "wenn"s dabei waren, und du dich nicht wohlfühlst dabei auf soviele Unvorhersehbarkeiten einzulassen (bzw keinem vertraust, das "vorhersehen" zu können), dann bleibe bei deiner eigenen Strategie! :-) Ein vernünftig diversifiziertes B&H-Depot verschiedener Assets wird vielleicht nie die allerbeste Rendite einfahren, aber eben auch nicht die schlechtmöglichste.

"Egal ob Frage eins mit ja oder nein beantwortet wurde, wie sieht diese "risikoadjustierte Rendite" langfristig gegenüber der Marktrendite aus? Ihr habt ja sicher Backtesting betrieben. Ich wüsste das gerne für ein maximal chancenorientiertes Portfolio."

Da könnte auch dieses Dokument ( https://de.scalable.capital/app//api/pdf/static?type=scalable_cones_explanation ) weiterhelfen, wo ganz unten eine Tabelle von "Beispielrenditen" für die verschiedenen VaR-Gruppen gelistet sind. Diese beziehen sich allerdings nicht auf die tatsächlichen dynamischen Portfolioallokationen, da anscheinend regulatorisch das Werben mit simulierten Backtests verboten ist (was ja auch verständlich ist, ich kann dir auch ein "perfektes" System im Backtest zusammenprogrammieren), so werden hier statische Allokationen ("deren relevante Merkmale weitestgehend der Anlagestrategie entsprechen") mit Indexdaten der letzten 15 Jahre benutzt. Für ein maximal "chancenorientiertes" (herrje, mir schmecken solche Marketingschlagwörter auch nicht) Portfolio mit VaR 25 sind da jedenfalls Werte von 8,5% durchschnittlicher Rendite pa angegeben, bei 11,7% Standartabweichung, so kommt man (mit RF) auch auf die Sharpe von 0,5-0,6 , was in der Tat besser ist als einfach nur die reine Aktienanlage im selben Zeitraum (waren ja auch 2 Crashs dabei ;-)

Achja und wenn einen interessiert mit welchen Assets diese Performance im statischen Portfolio erreicht worden ist, die bunte Grafik auf Seite 3 zeigt: 50% Schwellenländer-Bonds, 20% der (von dir geschmähte ^^) Asia Pacific Dividend 30, und nochmal 20% Developed Property REIT, der Rest vernachlässigbar. So schön kann halt Hindsight Bias sein, denn natürlich wäre man in der Praxis konkret ja eben nicht in diesen Assets mit dieser Aufteilung gewesen.

Auch ich habe schon im letzten Artikel kommentiert, was mir am benutzten ETF-Anlageuniversum auffällt (gibts keinen besseren Asien/Pazifik-ETF als den Dividendenfonds? Warum noch extra Dax wenn der doch im Europe schon mit drin ist ? etc.), da könnte Erik sicher noch was dazu schreiben, was Auswahlprozess und Kriterien angeht. Jeder Robo behauptet ja von sich, dass er für die Kunden immer nur die "besten" (günstigsten, liquidesten...) Fonds aussucht - das ist ja gerade einer der Haupt"leistungen", mit denen sie werben, es für den Kunden abzunehmen.

Wer allerdings selbst darüber hinaus schon eigene fortgeschrittene Ansprüche hat, muss sowieso statt Musterportfolio von der Stange lieber selbst das für ihn passende umsetzen.

@Wimi

"Ich habe (leider ohne Quelle) mal gelesen, dass die eigentliche Performance der Aktienmärkte nur an wenigen Tagen im Jahr zustandekommt. "

Du meinst sicher so Sachen wie "Hätten Sie die X besten Tage am Aktienmarkt verpasst, wäre Ihre Gesamtperformance soundsoviel schlechter gewesen...", sowas sieht man öfter mal im Netz, meist wenn es darum geht, dass als Argument gegen "Markttiming" (und für passive B&H-Anlage, die einfach immer investiert bleibt) zu nehmen. Mich hat das jedoch nie richtig überzeugt, denn diese "besten Tage" (wo die Indizes mal 5% und mehr hochspringen) treten meist in Phasen allgemein hoher Volatilität auf (clustering) -> und die sind meist mit einem Umfeld negativer Renditen verbunden. Anders gesagt, was nützt auch ein +5% Tag, wenn er in einem -20% Quartal stattfindet.

Du kannst ja auch mal beispielhaft nachschauen, wann die 3 besten Tage des DAX waren: Antwort, in den tiefen Verwerfungen des Crashs 2008, also einem Jahr was die meisten Anleger lieber ganz ausgelassen hätten.

Andersherum könnten ja auch Market-Timer einfach behaupten "Wir streichen einfach mal die X schlechtesten Tage weg, um zu beweisen, wieviel besser unsere Strategie gegenüber der B&H-Anlage hinterher ist". Wenn das (natürlich) Unfug ist, dann ist es das "beste-Tage-verpassen Argument" ja im Prinzip auch nur.

Erik, Scalable Capital sagt am 20. März 2016

@Chris,

zu Deinen Fragen bezüglich der ETF Auswahl:

DAX und Stoxx Europe - die Hinzunahme des DAX hat einen positiven Effekt auf die Portfoliosteuerung. Dax ETFs sind extrem günstig zu handeln und in DE mit sehr niedrigen TERs ausgestattet. Als exportorientierter Index hat er sein sehr ausgeprägtes Risikoprofil und eignet sich in bestimmten Marktumfeldern daher gut zur Risikosteuerung. Deutschland hat im Stoxx 600 ein Gewicht von 13% - die Überlappung ist daher überschaubar.

Pazifik-Region mit Select Dividend - auch die Aktien in dieser Region stellen eine Bereicherung bezüglich Risiko/Rendite und Korrelation im Zeitverlauf dar. Leider ist derzeit die Auswahl von ETFs die unseren Kriterien, insbesondere bezüglich steuerlicher Einfachheit und niedriger Kosten erfüllen, sehr überschaubar. Wir sind aber laufend auf der Suche nach einem noch besseren ETF und werden selbstverständlich einen Austausch für unsere Kunden automatisch und kostenlos vornehmen.

Besten Gruß

Erik

Chris sagt am 22. März 2016

@Erik

Das waren ja nichtmal unbedingt so sehr "meine" Fragen (da ich die Antworten dazu ja schon kenne), sondern wollte nochmal extra auf einen Punkt hinweisen den Christoph ins Spiel gebracht hat:

"Mehr auf dem Kasten als ich habt ihr ohne jeden Zweifel. Aber das kommt dann dabei raus? STOXX Europe, Core Dax, S&P 500 und mein persönlicher "Favorit" Dow Jones Asia Pacific Select Dividend 30? Also eine Lösung, die ich Börsen-Dämlack in 5 Minuten selbst ins Depot zaubern kann? Und dann soll ich laufend raus aus den Kartoffeln und wieder rein in die Kartoffeln weil eure Simulationen etwas vorhersagen, das sie eigentlich gar nicht richtig vorhersagen können?"

Beim Anblick der verwendeten "Zutaten" ist das sicher die naheliegendste Reaktion von Leuten, die sich schon selbst ein bischen mit B&H und ETFs beschäftigt haben. "Kenn ich schon", "Hab ich doch auch schon", "ahja, da wird wohl auch nur mit Wasser gekocht". Was auch absolut verständlich und vernünftig ist, denn wie gesagt, noch extra dafür zu bezahlen, diese allseits bekannten ETFs einfach nur "rumliegen" zu lassen (wie bei den meisten andern Robo-Anbietern), ist keine attraktive Leistung, sondern kann auch gleich günstiger selbst im Eigen-B&H gemacht werden.

(Auf der anderen Seite gilt natürlich auch, wenn ein Anbieter stattdessen nur irgendwelche nie-gehörten super-geheimen "Spezial"-Fonds verwendet, ist noch viel größere Vorsicht angebracht).

Apropos ETFs, da kann man schonmal neidisch auf die Insel schauen, wenn eure UK-Variante Vanguard-Fonds verwendet. Und dass die Briten generell so Sachen wie steuerbegünstigte Individual Savings Accounts haben, herrje, da könnte man sich hier in D-Land mal ruhig ne Scheibe abschneiden (hier passiert ja eher das Gegenteil wie der private Vermögensaufbau behindert wird). Aber nur so am Rande^^

Der entscheidende Punkt sind ja noch nichtmal die ETFs an sich, sondern was ihr damit macht, ie. euer Handelssystem, was euch vom Rest der Anbieter abheben soll. Wenn das System einigermaßen funktioniert, ist ja auch relativ egal welche/wieviele ETFs genau da verwendet werden (im simpelsten Fall würde es auch mit nur MSCI World, zwischen dem (und Tagesgeld) immer nach VaR-Ziel o.ä. hin und her geschichtet wird, noch einigermaßen funktionieren. Mehr Assets können natürlich Zusatznutzen durch dekorrelierteres Renditepotential bringen, aber der Effekt verwässert sich ja auch wieder mit steigender Assetzahl. Jedenfalls scheiden sich halt besonders am Handelssystem die Geister - es ist halt auch eine etwas komplexere Angelegenheit, und nur die wenigsten tun sich gern durch hunderte Seiten schwer verdaulicher akademischer Papiere lesen um die Hintergründe eurer ganzen Berechnungen etc zu verstehen, die nötig wären um auch bewußt unterscheiden zu können ob ihr eben nur "pseudowissenschaftliches Marketingblabla" macht, oder ob euer System wirklich eine valide Theorie dahinter hat und langfristig funktionieren, dh. Mehrwert bringen, wird.

Da wird u.U. noch viel Kommunikationsarbeit geleistet werden müssen, und ich finds ja toll dass du dir hier soviel Mühe gibst und deine Ausführungen sind auch gut nachvollziehbar - aber eigentlich sind das Infos die überhaupt schon auf eurer Webseite zu lesen sein sollten, und nicht nur erst hier in irgendeinem Blog im Kommentarbereich^^.

Mal als Beispiel, hier in diesem Video ( https://www.youtube.com/watch?v=Q6iv0CJvh3I& ) kann man (ab Minute 5:00) mal kurz einen kleinen Blick "unter die Haube" eures Systems bekommen. Sehr interessant, aber warum findet man das nur in so einem Video (was sich ja fast niemand anschaut), anstatt nicht einfach gleich auf eurer Webseite (bzw irgendwo im "Presse"-Bereich tief versteckt) ? Ich meine, es ist ja verständlich alles möglichst schön einfach und unkompliziert für die Leute zu halten die sich damit nicht weiter beschäftigen wollen, aber wie du an der Diskussion hier siehst brauchen manch andere Leute wieder lieber mehr Infos als zuwenige, um das Konzept zu verstehen und vertrauen zu können.

@Wimi

achja um noch auf deine weiteren Punkte einzugehen:

"Ich bin wirklich geneigt das mal auszuprobieren nur aus Interesse was dann mit meinem Portfolio in kleineren Krisen passiert."

Warte damit lieber noch ein bischen ab, bis der Anbieter auch einen einigermaßen belastbaren/ausreichend langen Echtgeld-Trackrecord zum veröffentlichen vorzuweisen hat, so kannst du dir die "Krisen"performance einfach lieber erstmal "von aussen" angucken und dann beurteilen ohne selbst gleich schon mit eigenem Geld dabei sein zu müssen. Dazu kommt noch, dass ja im Prinzip 24 verschiedene Portfolios angeboten werden (wegen VaR-Level), da müsste man auch noch weiter bestimmen können, welches Portfolio davon genau man mit was vergleichen will. In Börsencrashs werden natürlich die Portfolios mit dem niedrigsten VaR am "besten" gewesen sein, umgekehrt in Anstiegen können die mit hohem VaR am meisten partizipieren.

Ich kann mir schon vorstellen dass sie alle mehr oder weniger die letzten Monate "besser" (dh. zumindest weniger volatil, oder mit kleineren Verlusten) als die Märkte überstanden haben, da die Allokationen sich schon mit den zunehmenden Turbulenzen im letzten halben Jahr aus Aktien raus in Anleihen reinbewegt haben, so zeigts zumindest das Gewichtungs-Tool an. Und da die Märkte in den letzten 12m eher unruhig und absackend waren, wird sich natürlich so ziemlich jedes Portfoliokonzept, das auf diversifizierter Downside Protection beruht, risikojustiert besser geschlagen haben (wie gesagt ist das bei Aktienhausses eben auch wieder anders).

"FOMA" (fear of missing out) hat schon oft mehr Schaden als nötig angerichtet, ich würde lieber abwarten bis man konkret was zum vergleichen hat anstatt vorschnell in irgendwas zu investieren was man noch nicht einschätzen kann, nur weil man vllt irgendwas "verpassen" würde.

"Ich konnte die kleineren Korrekturen der Aktienmärkte der letzten Monate für Nachkäufe nutzen."

Solches antizyklisches Dip-Buying findet hier eher nicht statt. Im Gegenteil, wenn die VaR-Projektionen der Anlagen sich über das Ziel hinausentwickeln wird ja anpassend umgeschichtet (d.h. risikoreiche Anlagen verkauft um wieder auf Ziel-VaR zurechtzustutzen), anstatt verbilligend nachzukaufen (was ja auch nur funktioniert solang die "kleine Korrektur" eben nur ne kleine Korrektur bleibt und der Aufwärtstrend danach schön weitergeht, anstatt dass dann mal wirklich der große Crash kommt, vor dem einen das System ja einigermaßen bewahren soll)

"Nach Daniel Kahnemann (Regression zum Mittelwert) würde ich sagen, damit ist ein leichtes Market Timing für buy-and-hold-Anleger sehr wohl möglich ist. "

Daniel Kahnemann hat mit der Mean Regression eigentlich weniger zu tun, das wurde schon lange vor ihm von anderen gefunden, und er ist eher für Behavioral Finance bekannt.

Das Problem bei der Regression zum Mittelwert ist halt immer die einigermaßen korrekte Bestimmung wo dieser "Mittelwert" denn auch dann tatsächlich liegen sollte ? ;-) Und dass man nie genau weiß, wie lange/stark sich Abweichungen davon (nach oben UND nach unten) anhalten bzw fortsetzen. Da können manchmal schon ganz schön viele Jahre bzw. Prozente dazwischenliegen ^^ The market can stay irrational for much longer than you can stay solvent.

Ob es nun schon ein "leichtes Markettiming" ist, nach jedem kleinen Dip verstärkt nachzukaufen, weiß ich nicht ("möglich" ist das sicher, aber "wirksam" ist ne andere Frage die erst quantifiziert werden müsste). Für mein Hauptdepot (B&H) bringe ich einfach jeden Monat regelmäßig eine feste Summe ins Portfolio nachinvestiert, egal wie die Kurse grad stehen. Quasi wie Sparplan, nur eben nicht automatisch auf alles verteilt, sondern damit wird gezielt jeweils nur die Anlage zugefüttert, die am meisten unter der Soll-Gewichtung zurückentwickelt ist. Praktisch wirkt sich das auch wie antizyklisches Dip-Buying aus, nur dass ich mir keine Gedanken drum machen muss, was nun wirklich ein "Dip" ist (investiere ich schon bei einem 5% Rückgang, oder ist erst bei 10% eine "lohnenswerte Korrektur" ? Egal, ich investiere einfach immer).

"Was ist bei Deflation oder bei Hyperinflation?"

"Allgemein ist ja in allen Anlageklassen nicht mehr so viel zu holen, nach dem was wir so gesehen haben, oder seht ihr das anders? Inwieweit werden solche Fundamentaldaten bei scalable mit berücksichtigt?"

In ihrem Modell werden die relevanten Inputs hpts alle aus den reinen Kursdatenentwicklungen abgeleitet. Inflation oder Deflation haben da also nur einen eher "indirekten" Einfluss, nämlich wie sie sich eben auf die Kursdaten auswirken. Da wird ja auch nicht subjektiv/diskretionär gemanagt ala "wir erwarten mittelfristig eine Inflation von X,Y Prozent und schichten deshalb in Anlage Z um", es geht nur um die Portfolio-VaR Projektion. Genauso sitzt da auch niemand der Unternehmensbilanzen analysiert und sagt "aktuell erscheint uns der Markt als überbewertet, wir ziehen uns lieber zurück", gehandelt wird einfach nur immer dann wenn eben erst die VaR das Signal gibt.

"Die rechtlichen Probleme mit der Angabe von Musterportfolios wurden ja schon mal angesprochen, aber vielleicht könnte man ja ein kleines Backtesting-Beispiel von 2006 bis 2010 machen, wo der Finanzwesir seine Performance mit einer anonymen Risikoallokationssoftware vergleicht. ;-) Vielleicht auch die anderen maximum Drawndown szenarien des Finanzwesirs mit ein paar guten folgenden Jahren."

Der Finanzwesir hat m.W. noch nie seine private Portfolio-Performance veröffentlicht, und warum sollte er es auch ? Er will ja niemandem was beweisen oder verkaufen.

Für Vergleiche werden lieber so allgemeine Benchmarks wie MSCI World + Euro Aggregate Bonds benutzt. Dafür sind die Daten auch leicht öffentlich für jeden zu finden und niemand muss sein privates Depot dafür offenlegen (was ja auch individueller bestückt und keine gute Vergleichsgrundlage ist). So machts zB. Morningstar.

In den Vertragsunterlagen von Scalable ( https://de.scalable.capital/app/api/pdf/static?type=scalable_terms_and_conditions , Seite 8) steht zum Beispiel was für Benchmarks die selbst benutzen. MSCI World und Euro Tagesgeld, in verschiedenen Gewichtungen entsprechend der Verlustlevels.

Da der Tagesgeldzins vernachlässigbar bzw seit längerem null ist, kann sich jeder leicht die Performance des Benchmarks im Kopf ausrechnen anhand des MSCI World Anteils. So hätte eine 50/50 Anlage im Crash 2008 eben die Hälfte des MSCI World-Verlusts produziert (also ca -25%). Für diesen Benchmark will Scalable nur etwa 15% Verlust einfahren.

Oder wers ganz "chancenorientiert" haben will (also Benchmark ist fast vollständig nur MSCI World), versucht dir Scalable eine Rendite zu bringen die in etwa der des MSCI World entspricht, aber nur mit der Hälfte des möglichen Verlust (VaR 25% versus -50% beim MSCI World).